С помощью нейросетей аферисты могут максимально реалистично сгенерировать голос и внешность любого человека. Так они могут даже оформить кредиты на своих жертв. О новой опасности читайте на NUR.KZ.

Мошенники – самые преданные фанаты новых технологий. Они активно осваивают их и впоследствии используют в своих преступных намерениях. Это также касается искусственного интеллекта и нейросетей.

Например, ранее мы рассказывали о том, что с их помощью аферисты создают дипфейки – они генерируют голоса своих жертв и затем рассылают аудиозаписи их контактам с просьбой выслать денег.

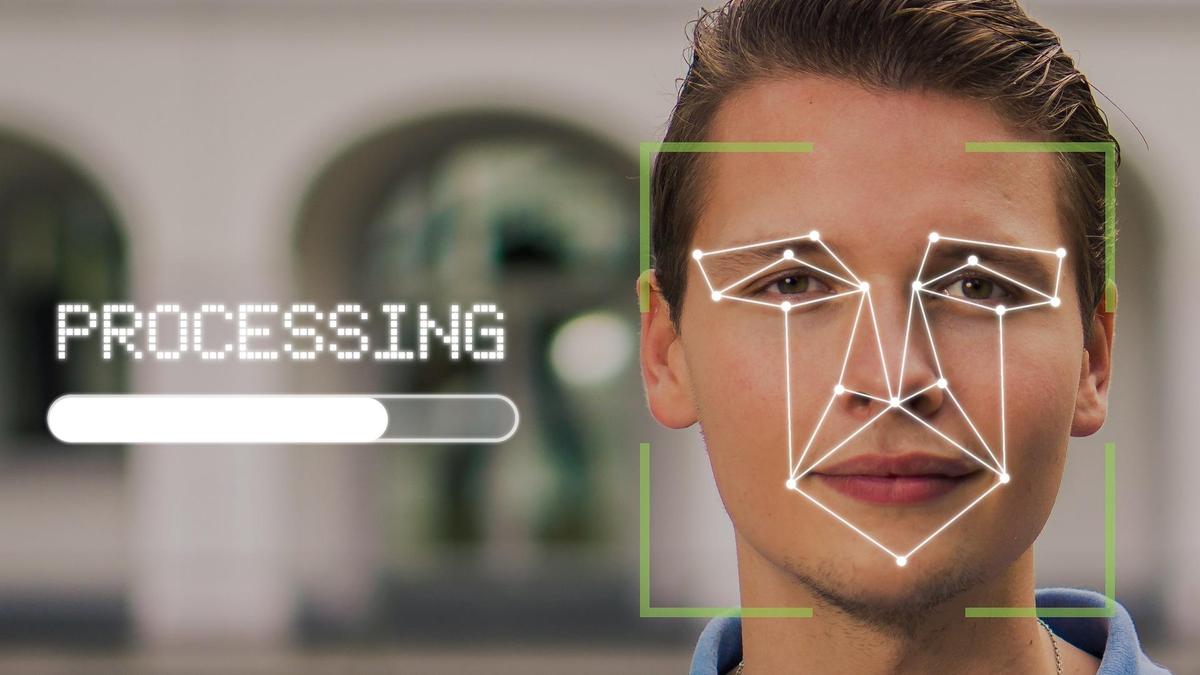

Однако искусственный интеллект может воссоздать не только голос, но и сгенерировать внешность человека. Причем, как рассказывают эксперты медиа-портала FinGramota, уже сейчас дипфейки настолько реалистичные, что рядовым гражданам их практически невозможно разоблачить.

Ранее казахстанцы уже сталкивались с фальшивой рекламой, в которой использовались дипфейки. Напомним, в прошлом году мошенники использовали личность президента Казахстана в рекламе, где его "двойник" рассказывал о "разработке новой инвестиционной платформы", которая якобы позволила бы зарабатывать гражданам большие деньги.

Стоит отметить, что жертвами дипфейков могут стать не только знаменитые люди. Под удар могут попасть и простые казахстанцы.

Как рассказывают эксперты, с помощью нейросетей злоумышленники могут полностью подделать чужую личность для того, чтобы получить доступ к ее банковскому счету, обналичить деньги и оформить подставные кредиты.

Например, сейчас в социальных сетях распространяется сообщение о том, что некоторые казахстанцы уже якобы сталкивались с новой схемой – их внешность и голос были скопированы во время видеозвонка и затем использованы для прохождения биометрии в банковских приложениях.

При этом сервисы, через которые можно создать дипфейки, достаточно распространены в Интернете. При желании пользователь за несколько минут может создать "живую" копию другого человека с помощью всего одного изображения и голосовой записи длиной в несколько секунд.

Такой дипфейк не будет отличаться высоким качеством, и внимательный пользователь сразу определит подделку. Однако казахстанцам все равно лучше соблюдать осторожность и не принимать видеозвонки от незнакомых контактов.

Оригинал статьи: https://www.nur.kz/nurfin/personal/2068689-kak-moshenniki-ispolzuyut-zhivye-izobrazheniya-svoih-zhertv-dlya-krazhi-ih-deneg/

Загрузка комментариев