Мошенники могут подделать личность родных потенциальной жертвы или даже "оживить" уже умершего человека. Таким образом они получают доступ к чужим банковским счетам. Подробности читайте на NUR.KZ.

Искусственный интеллект (ИИ) активно развивается и используется во многих сферах жизни. Однако новые технологии применяются не только во благо – мошенники давно взяли их на вооружение.

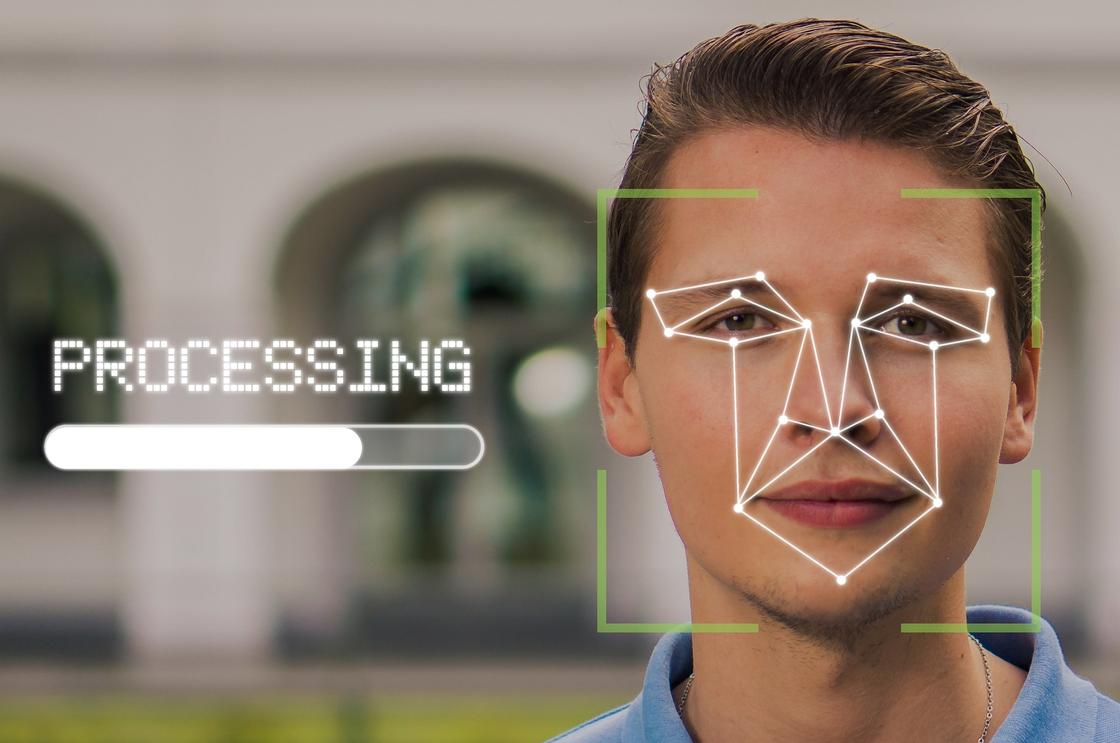

Часто аферисты используют ИИ для создания дипфейков – фальшивых фотографий, видеороликов или аудиозаписей, обработанных нейросетями. С помощью такой технологии можно создать, например, ролик, в котором определенный человек будет произносить слова, которые в реальной жизни никогда бы не сказал.

В Казахстане такие случаи уже фиксировали. Напомним, в прошлом году мошенники распространяли фейковый видеоролик, в котором сгенерированный ИИ "президент Казахстана Касым-Жомарт Токаев" призывал граждан инвестировать в новую платформу Илона Маска.

Как отмечают в Агентстве РК по регулированию и развитию финансового рынка, дипфейки могут использоваться точечно, то есть для обмана определенных людей.

Например, злоумышленники могут подделать чужую личность, чтобы получить доступ к банковскому счету, обналичить его и оформить подставные кредиты. Или даже выкрасть данные умершего человека и "оживить" его для получения доступа к банковским онлайн-сервисам.

Случаев мошенничества с использованием технологии дипфейка против отдельных людей в Казахстане пока не фиксировалось, однако это не значит, что граждане страны находятся в безопасности. В мире уже были случаи, когда дипфейки приводили к миллионным убыткам.

На текущий момент ИИ все еще допускает ошибки в своих "творениях", поэтому казахстанцам стоит обращать внимание на странное моргание человека либо его пропадание из видео, слова невпопад, легкое заикание, роботизированный тон или другие признаки нереалистичной "картинки".

Не стоит забывать, что дипфейки могут использовать не только для видео, но и во время звонка. Поэтому, если звонит близкий или знакомый и просит срочно перевести деньги, казахстанцам следует завершить разговор и перезвонить ему, чтобы уточнить, действительно ли был звонок от него.

Важно отметить, что современные технологии применяются не только злоумышленниками, но и всеми банками.

В Казахстане в настоящее время действуют правила, требующие использования двухфакторной аутентификации и проверки биометрических данных при предоставлении финансовых услуг. Однако это не освобождает граждан от необходимости сохранять бдительность.

Эксклюзивный контент и новости только для вас! Подпишитесь на Telegram!

Подписаться

Оригинал статьи: https://www.nur.kz/nurfin/personal/2199078-neyroseti-i-dipfeyki-kak-iskusstvennyy-intellekt-pomogaet-krast-dengi-u-kazahstancev/